Introduction

L’intelligence artificielle (IA) est une des technologies les plus révolutionnaires de ces dernières années. Elle a déjà transformé de nombreux secteurs, et l’industrie de l’embarqué ne fait pas exception.

Les GPUs (Graphic Processing Unit) ont joué un rôle crucial dans le développement de l'IA et dans l’accélération des solutions de deep learning en particulier. Aujourd'hui, en plus d'alimenter les consoles de jeux, certains GPU fournissent des fonctions de calcul de pointe essentielles à de nombreuses applications embarquées Mil-Aéro ou industrielles : contrôle commande, aide à la décision, guerre Electronique, surveillance (Radar Sonar), cyber sécurité etc.

Mais ces applications ont leurs contraintes, pour les résumer nous employons souvent dans notre jargon l‘acronyme Swap-C (Size, Weight, And Power - Cost), et l’offre de solutions graphiques proposée par les Intel, AMD, et NVIDIA est logiquement destinée à un marché plus large (PC, Jeux Vidéo, CAO) dont les enjeux techniques sont bien différents à plusieurs égards.

Quels sont les différents types de GPU proposés par le marché?

A la fin des années 90, les GPU ont été développés pour améliorer les capacités graphiques des ordinateurs, et décharger les processeurs des fonctions d’affichage qui leurs étaient dévolues jusqu’alors. Avec le temps, ils sont devenus plus flexibles et programmables, offrant des capacités de calculs nettement améliorées jusqu’à dépasser celles des processeurs pour certaines applications. En même temps que les GPU se sont développés pour traiter des effets visuels de plus en plus réalistes, ils se sont transformés en véritables unités de traitements de données haute performance pour devenir des GPGPU (general-purpose computing on graphics processing units).

Avec les GPUs virtuels, le marché offre aujourd’hui 3 types de solutions, mais dans le cadre des applications embarquées seuls les GPU intégrés et les GPU discrets ont un intérêt.

GPU intégrés

Les processeurs mais aussi les FPGA (Field Programmable Gate Arays) dotés d’un GPU entièrement intégré (iGPU) permettent de développer des systèmes plus efficaces en terme d’échanges grâce à un fort couplage entre les cœurs numériques, plus légers, moins consommateurs et donc moins coûteux.

De nos jours, l’utilisation des iGPU pour les systèmes embarqués reste pertinente pour les intégrateurs qui cherchent à optimiser leurs calculateurs en exploitant principalement les interfaces vidéo ou d’affichage des puces avec des ressources graphiques modérées.

Cependant, et bien que l’offre des fabricants de processeurs s’enrichisse continuellement, l’utilisation de GPU dédiés ou discrets s’avère souvent nécessaire pour les applications gourmandes en traitement 3D ou en calcul parallèle telle que le deep learning.

GPU discrets :

Les GPU discrets ou dGPU, sont des processeurs graphiques distincts du CPU qui possèdent leurs propres unités de traitement (Cœurs/Cores) et leurs mémoires vidéo intégrées (RAM). Les dGPU sont généralement utilisés dans des applications exigeantes nécessitant des capacités graphiques puissantes et sont particulièrement efficaces et performant pour effectuer de grandes quantités d’opérations en parallèle. À ce titre, ils sont recommandés pour supporter des fonctions de deep learning et d’Intelligence Artificielle lorsqu’ils sont combinés à des FPGA ou des processeurs. Ils ont néanmoins l’inconvénient d’être très énergivores et de nécessiter des systèmes de refroidissement très sophistiqués.

Dans cette catégorie de processeurs graphiques, nous allons retrouver les GPUS discrets Intel® Arc™ et les bien connues plateformes RTX™ de NVIDIA.

Mais il existe d’autres types de GPUs discrets moins consommateurs et très utiles dans nos calculateurs hautes performances (HPC) durcis :

Les solutions SM750 et SM768 de Slicone Motions dont la principale ambition est de servir de passerelles entre les unités de traitements démunies de capacités graphiques et les écrans, ou encore les GPU Mali de la société ARM dont le maître mot est l’efficacité énergétique et que nous retrouverons plutôt dans le domaine des smartphones, sont deux très bons exemples de GPUs discrets difficiles à catégoriser.

De même, ces dernières années nous avons vu l’apparition sur le marché des solutions hybrides de FPGA et processeurs hauts de gamme intégrant des GPU discrets :

AMD propose le MPSoC Zynq™ UltraScale+™ qui met en œuvre dans la même puce plusieurs cœurs processeur Cortex, de la ressource FPGA et un GPU Mali, solution particulièrement adaptée aux dispositifs automobiles ou de vétroniques.

Les dernières générations de processeurs CoreI sont bâties sur l’architecture TigerLake intégrant le nouveau GPUd IrisX. Avec ce « combo » de 2 puces hautes performances dans un seul composant et le support de la technologie Deep Learning Boost, Intel enrichit sa gamme Embedded (Gamme de température industrielle, cycle de vie étendu) avec un CPU qui apporte une réelle réponse aux besoins croissants de ressources dédiées à l’accélération d’IA dans le domaine de l’embarqué.

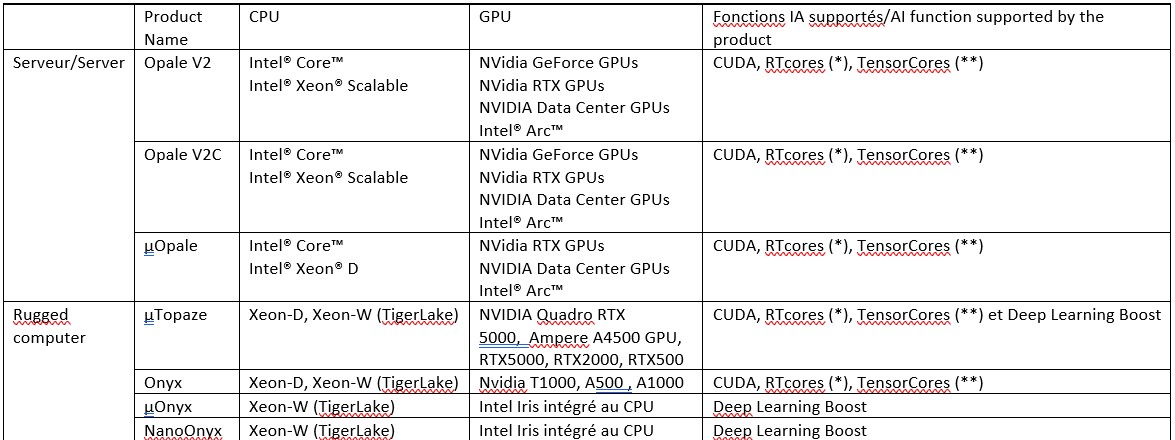

De fait, Ecrin Systems a à sa disposition un panel de solutions très large, dans des facteurs de forme très variés (PCIe, MXM, XMC, VPX ou autre SFM tel que le Jeston) pour répondre aux exigences toutes aussi variées de ses clients en matière de GPU. Les besoins pouvant aller de la simple interface vidéo avec un minimum de capacité de traitement 3D jusqu’à d’importantes puissances de calcul pour du traitement d’IA, nous avons élaboré nos PC, serveurs et calculateurs hautes performances durcis pour qu’ils puissent répondre aux attentes du plus grand nombre :

(*) Les cartes RTX comportent des « cœurs RT » pour accélérer les opérations mathématiques nécessaires à la simulation des rayons (ray tracing : la génération d'images informatiques en suivant la direction de la lumière d'une caméra).

(**) Les cœurs Tensor sont une nouvelle technologie avancée de NVIDIA autorisant des calculs en précision mixte. Cette innovation offre d’importants gains de performance pour toutes les charges de travail d’IA et HPC.